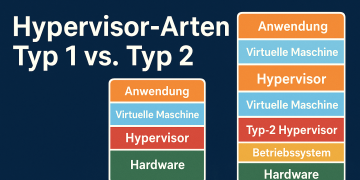

Proxmox VE unterstützt zwei grundlegend unterschiedliche Ansätze zur Virtualisierung: Virtuelle Maschinen (VMs) auf Basis von KVM und LXC-Container. Beide Formate haben klare Stärken und typische Einsatzbereiche.

Virtuelle Maschine (VM)

Virtuelle Maschinen stellen einen kompletten Computer nach: eigenes UEFI/BIOS, eigener Kernel, eigenes Betriebssystem. Genau deshalb eignen sie sich überall dort, wo du maximale Trennung zwischen Host und Gast brauchst. Du kannst völlig unterschiedliche Betriebssysteme parallel betreiben – etwa Windows neben FreeBSD oder einem alten Linux, das nur für eine Legacy-Anwendung existiert. Dank der vollständigen Emulation lassen sich spezielle Kernel-Module laden oder ganze Geräte per PCI-Passthrough durchreichen, zum Beispiel eine Grafikkarte für GPU-Beschleunigung. Kurz: Wenn Sicherheitsanforderungen hoch sind, Hardware direkt an den Gast soll oder ein eigenes Kernel-Setup nötig ist, greifst du zu einer VM.

LXC-Container

LXC-Container teilen sich den Kernel des Host-Systems, isolieren aber Prozesse und Dateisystem sauber voneinander. Dadurch starten sie in Sekunden, verbrauchen kaum zusätzlichen RAM und lassen sich sehr dicht auf derselben Hardware stapeln. Das macht Container ideal für leichtgewichtige Dienste wie Web-, Datenbank- oder API-Server, die du häufig kopierst, aktualisierst oder wegwirfst. Auch in CI-Pipelines, Test-umgebungen oder auf schwächerer Hardware (etwa Home-Labs und Mini-Servern) spielen Container ihre Effizienz aus – jeder Dienst läuft separat, ohne den Overhead einer vollständigen VM. Overhead in dem Sinne, dass keine Bloadware wie Spiele oder unnötige Texteditoren oder eine Desktopumgebung installiert wird, die Speicher und RAM belasten würde.

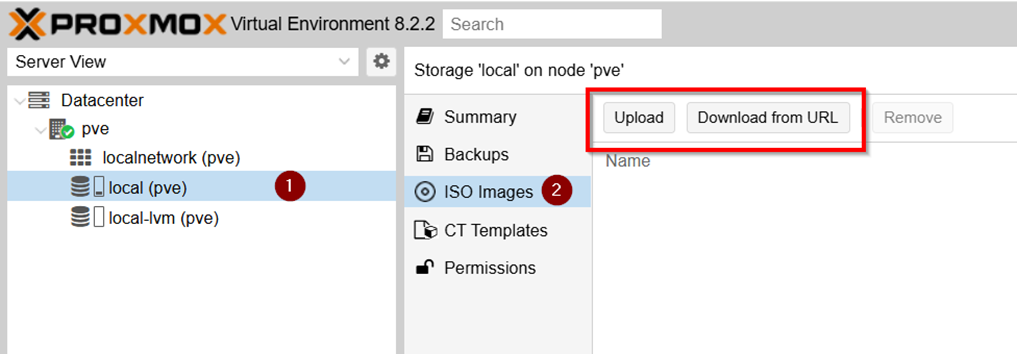

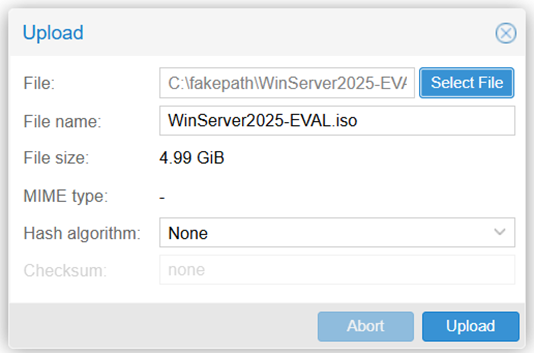

Um eine Virtuelle Maschine (VM) erstellen zu können, muss man zuerst die entsprechende ISO bei Proxmox hochladen. Dazu geht man wie folgt vor

Möglichkeit 1: Hochladen der ISO-Datei des eigenen Rechners Dateisystem. Dazu klickt man auf „Upload“ oder „Hochladen“

(je nach eingestellter Sprache) und wählt seine ISO-Datei aus, und ladet sie hoch.

Möglichkeit 2: Das Hochladen einer ISO-Datei über die „Download from URL“ Variante. Hierbei ladet Proxmox automatisch die ISO des Downloads URL des Anbieters herunter. Ähnlich wie bei wget, wo ebenfalls Dateien über HTTP heruntergeladen werden können.

Je nach Internetverbindung kann der Upload unterschiedlich lang dauern. Anschließend ist die ISO hochgeladen und kann bei einer VM-Erstellung verwendet werden.

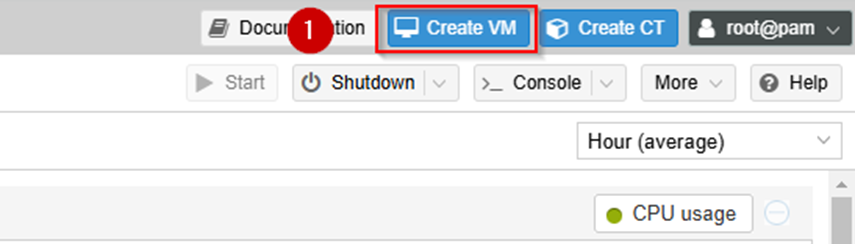

Um eine VM (Virtual Machine) klickt man auf den oberen blauen Button „Create VM“

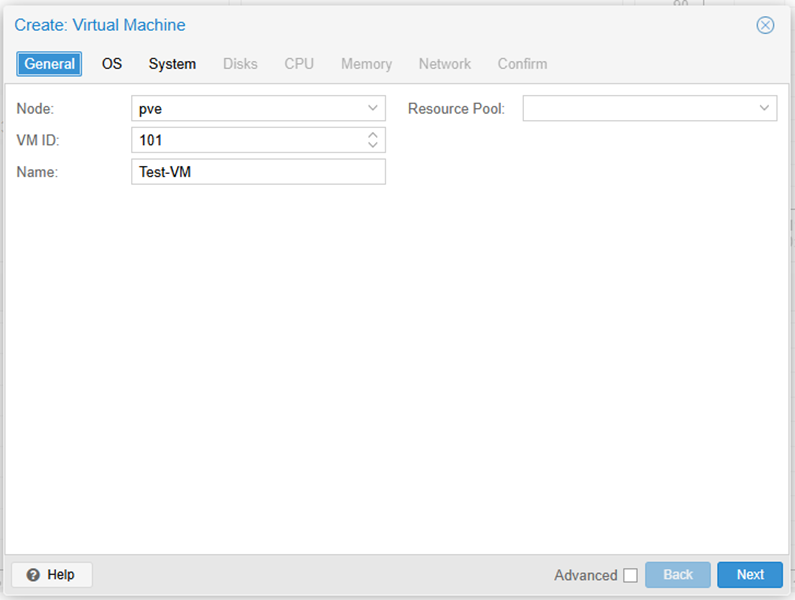

Anschließend öffnet sich folgendes Fenster:

In diesem Dialogfeld legst du zunächst die Basisdaten deiner neuen virtuellen Maschine fest. Am wichtigsten ist hier der Name, unter dem die VM später in der Übersicht erscheint – wähle etwas Aussagekräftiges, etwa „Ubuntu-Server“ oder „Win11-Test“.

Die übrigen Felder kannst du fürs Erste unverändert lassen:

Node – das ist der physische Proxmox-Host, auf dem die VM laufen wird. In einer Einzelserver-Umgebung steht hier ohnehin nur ein Eintrag, bei mehreren Hosts kannst du die VM später jederzeit migrieren.

VM ID – eine fortlaufende Nummer, die Proxmox automatisch vergibt. Sie dient als eindeutiger Bezeichner im Hintergrund, zum Beispiel für Konfigurationsdateien und Backups. Manuell ändern musst (und solltest) du sie normalerweise nicht.

Ressource-Pool – Pools fassen VMs zu Gruppen zusammen, um Rechte oder Quotas zentral zu verwalten. Wenn du noch keine speziellen Pools eingerichtet hast, bleibt dieses Feld leer, die VM landet dann automatisch im globalen „root“-Pool.

Kurz gesagt: Vergib einfach einen sinnvollen Namen, lasse Node, VM ID und Ressource-Pool vorerst auf ihren Voreinstellungen stehen und klicke auf „Weiter“. Alles Weitere kannst du später bei Bedarf anpassen.

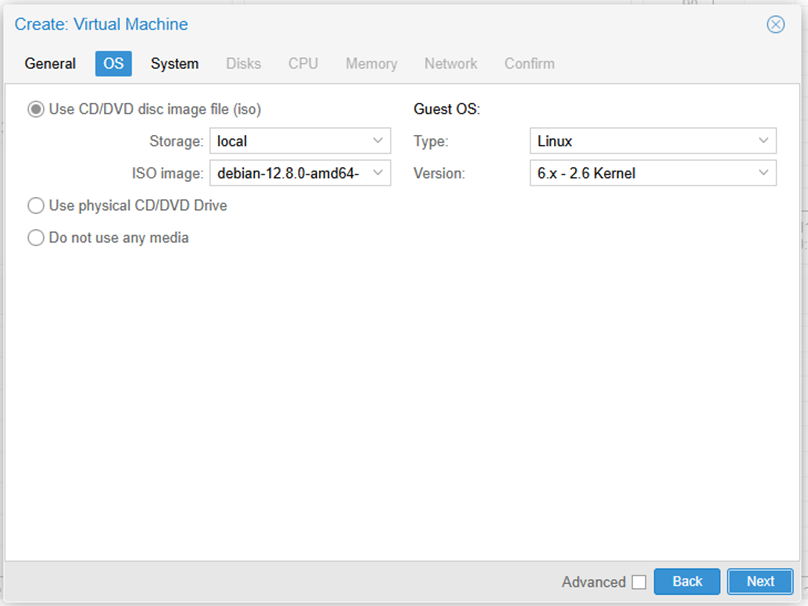

Als nächstes müssen wir das Betriebssystem auswählen, was installiert werden soll. Hierfür verwenden wir das ISO was wir in unseren ISO-Container hochgeladen haben.

Das gezeigte Fenster ist der dritte Dialog („System“) des VM-Assistenten. Hier legst du fest, wie die virtuelle Hardware unter der Haube aussehen soll. Ein kurzer Rundgang durch die Felder:

- Graphic card: Emuliert zunächst eine Standard-Grafikkarte, was für Konsolen-VMs oder schlanke Linux-Server völlig ausreicht. Für grafische Desktops (Windows 10/11 oder moderne Linux-Distributionen) kannst du später auf VirtIO-GPU umstellen; für ältere Windows-Versionen bietet sich QXL an.

- Machine: Standardmäßig benutzt Proxmox das alte Intel-Chipset i440fx, das sehr kompatibel ist. Wer aktuelle Betriebssysteme oder PCIe-Passthrough nutzt, wählt besser Q35, weil es den moderneren PCI-Express-Bus emuliert.

- BIOS: Voreingestellt ist SeaBIOS, also klassisches Legacy-BIOS. Brauchst du UEFI-Boot, Secure Boot, Festplatten > 2 TB oder möchtest Windows 11 installieren, stelle hier auf OVMF (UEFI) um.

- SCSI Controller: VirtIO SCSI single ist die empfohlene Option: paravirtualisiert, schnell und mit TRIM-Support. Linux bringt die passenden Treiber von Haus aus mit; für Windows findest du sie auf der VirtIO-Treiber-ISO.

- Qemu Agent: Ein Häkchen aktiviert den QEMU Guest Agent. Damit kann Proxmox die IP-Adresse der VM anzeigen, Snapshots sauber koordinieren und den Gast ordnungsgemäß herunterfahren. Unter Linux installierst du einfach das Paket

qemu-guest-agent; unter Windows steckt er ebenfalls im VirtIO-Treiber-Bundle. - Add TPM: Fügt der VM einen virtuellen TPM 2.0-Chip hinzu. Pflicht für Windows 11 und hilfreich für BitLocker-Verschlüsselung. Funktioniert nur zusammen mit OVMF (UEFI).

Für aktuelle Windows-Versionen solltest du deine VM im UEFI-Modus (OVMF) starten. Linux-Gäste und viele andere Betriebssysteme fühlen sich hingegen mit dem voreingestellten SeaBIOS pudelwohl.

Brauchst du mehr virtuelle Hardware, kannst du jederzeit eine leistungsfähigere Grafikkarte (z. B. VirtIO-GPU oder QXL) oder einen TPM-2.0-Chip hinzufügen – Letzterer ist Pflicht, wenn du Windows 11 installieren oder BitLocker verschlüsseln möchtest.

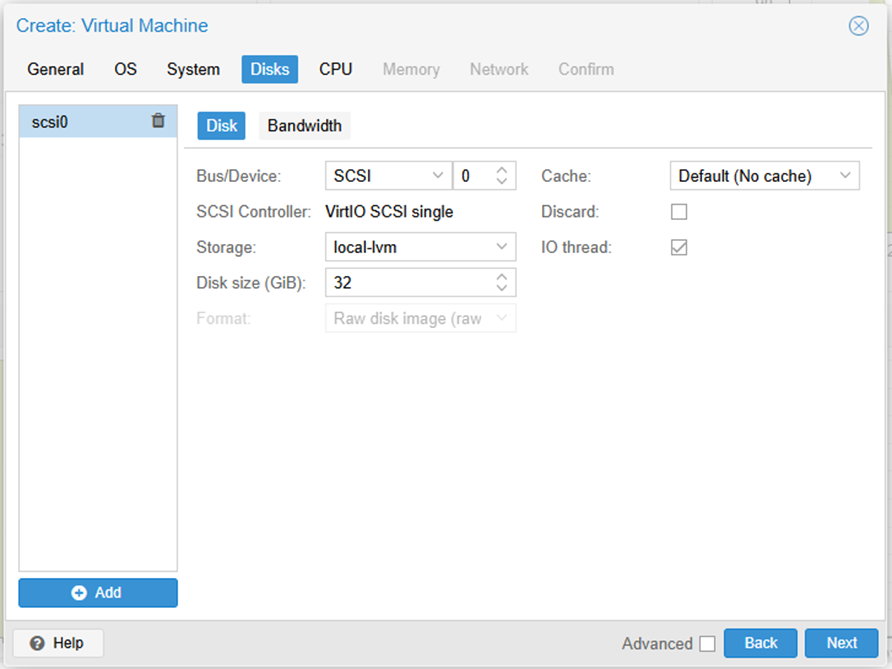

Beim Anlegen der VM bist du jetzt im Reiter Disks angekommen. Dieser Dialog legt fest, auf welchem Storage die virtuelle Festplatte liegt und mit welchen Performance-Optionen sie betrieben wird.

Linke Spalte („scsi0“)

Die aktuelle Festplatte heißt scsi0. Über die Schaltfläche Add kannst du später weitere Laufwerke hinzufügen (z. B. eine zweite Datenplatte).Bus/Device = SCSI 0

Proxmox bindet das Laufwerk als SCSI-Gerät mit der Target-ID 0 ein. Andere Bus-Typen (SATA, VirtIO-Block, IDE, NVMe) lassen sich über das Dropdown auswählen.SCSI Controller = VirtIO SCSI single

Das ist der moderne, paravirtualisierte Controller: hoher Durchsatz, mehrere Warteschlangen, TRIM-Support. Bleibt fast immer so.Storage = local-lvm

Die Platte kommt in den Thin-Pool local-lvm (Standard-Speicher auf der Systemfestplatte). In einem Mehr-Disk-Setup könntest du hier deinen separaten Daten-Pool wählen.Disk size = 32 GiB

Vorgesehene Kapazität der virtuellen Festplatte. Lässt sich frei anpassen; bei LVM-Thin wird nur der tatsächlich genutzte Platz belegt.Cache = Default (No cache)

Keine zusätzliche Host-Seiten-Cache-Schicht. Für Produktions-VMs ist das meist die sicherste Option; Writeback-Caching steigert Performance, erhöht aber das Risiko bei Stromausfall.Discard (Checkbox, leer)

Aktiviert TRIM/UNMAP. Setz hier ein Häkchen, wenn das Gast-OS TRIM unterstützt – so gibst du freigewordenen Speicher an das Thin-Provisioning zurück.IO thread (Checkbox, aktiv)

Jede Festplatte erhält einen eigenen I/O-Thread. Das verbessert Latenz und Parallelität, vor allem bei Mehrkern-Hosts.

Rechts unten kannst du mit Back zum vorherigen Schritt springen oder mit Next zu den CPU-Einstellungen wechseln. Der Advanced-Schalter blendet weniger gebräuchliche Detailoptionen ein (z. B. Emulationstyp oder SSD-Flag).

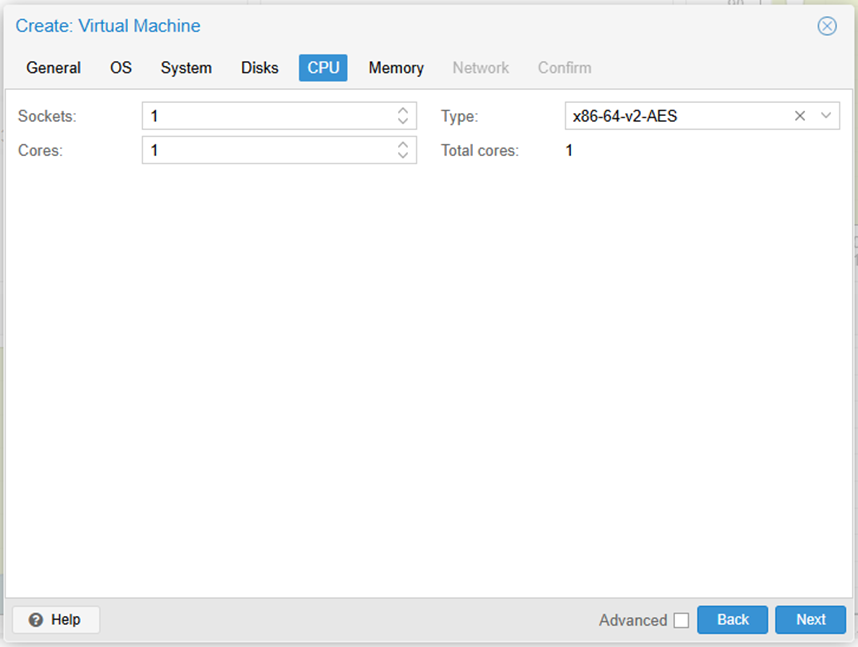

In Proxmox (und generell in der Virtualisierung) legst du die Rechenleistung einer VM über zwei Werte fest: Sockets und CPU-Kerne.

Sockets stehen für virtuelle Prozessoren, die einem physischen CPU-Sockel des Hosts nachempfunden sind. Eine VM mit zwei virtuellen Sockets wird für das Gast-Betriebssystem wie ein Dual-CPU-System erscheinen – wichtig für manche Anwendungen oder Lizenzmodelle, die nach „Prozessoren“ lizensieren.

CPU-Kerne sind die eigentlichen Recheneinheiten innerhalb eines Sockets. Je mehr Kerne du pro Socket zuweist, desto größer das Leistungs-Potenzial der VM.

Die Summe aus (Sockets × Kerne) ergibt die Zahl der virtuellen CPUs (vCPUs), die der Gast nutzen kann. Beispiel: 2 Sockets × 4 Kerne = 8 vCPUs. – Überlege also, ob deine Workloads eher von mehreren Sockets (wegen Lizenzierung oder NUMA-Optimierung) oder schlicht von vielen Kernen profitieren, und passe die Werte entsprechend an.

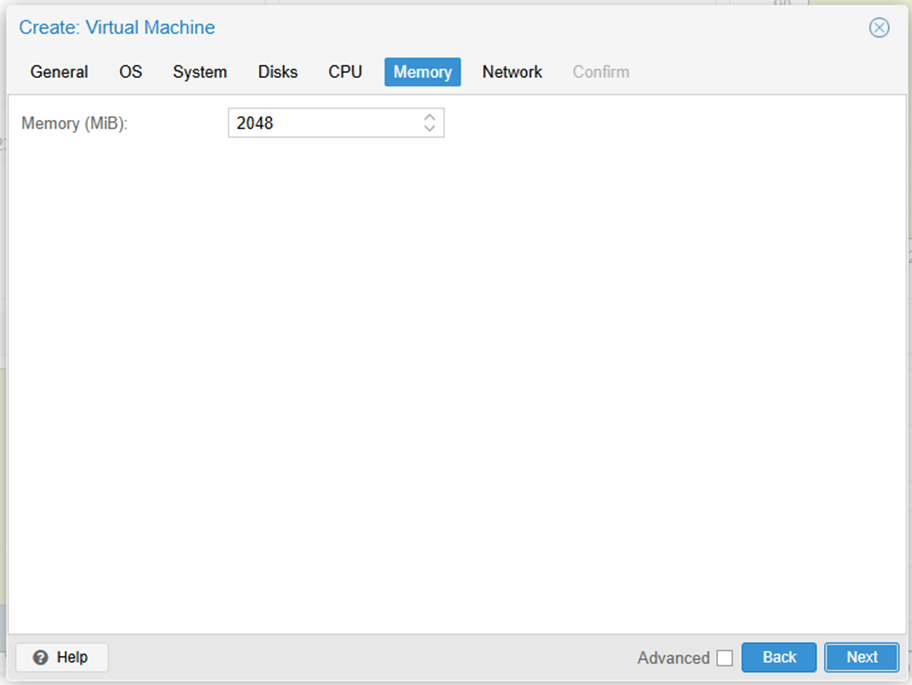

Proxmox erwartet den Wert für Arbeitsspeicher in MiB (Mebibyte). Diese binäre Einheit basiert auf Zweierpotenzen; deshalb gilt:

1 GiB (Gibibyte) = 1024 MiB

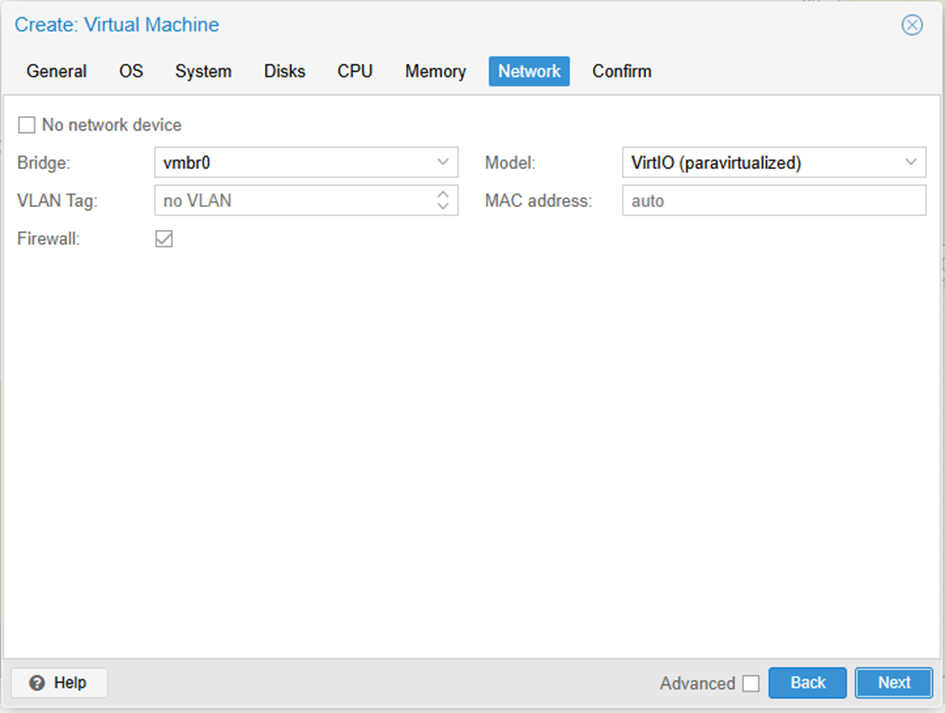

- Bridge: vmbro ist die Standard-Netzwerkbrücke deines Hosts. Sie verbindet die virtuelle Netzkarte der VM direkt mit dem physischen LAN, als hinge noch ein weiterer Rechner an deinem Switch. Betreibst du mehrere Brücken (z. B. für interne Netze oder Storage-Traffic), kannst du hier umschalten.

- Model:

VirtIO (paravirtualized)liefert die beste Performance, weil der Treiber eng mit dem Hypervisor zusammenarbeitet. Linux erkennt ihn von Haus aus; bei Windows musst du den VirtIO-Treiber von der Red Hat-ISO einbinden. - VLAN Tag: Wenn deine physische Infrastruktur VLANs nutzt, trägst du hier die VLAN-ID (z. B. 10, 20, 30) ein. Die VM sendet dann getaggte Frames, ohne dass du in der VM selbst VLANs konfigurieren musst. Steht das Feld auf „no VLAN“, hängt die VM ungetaggt (untagged) an der Bridge.

- MAC address:

autoerzeugt beim Anlegen eine eindeutige MAC. Willst du eine feste Adresse (etwa wegen Lizenzservern oder DHCP-Reservierungen), gib sie hier manuell im FormatAA:BB:CC:DD:EE:FFein. - Firewall: Haken gesetzt bedeutet: Die VM unterliegt den Proxmox-Firewallregeln, die du später auf Datacenter-, Host- oder VM-Ebene definierst. Entferne das Häkchen, wenn die VM ganz ohne die Proxmox-Firewall laufen soll (z. B. bei eigenen virtualisierten Firewalls).

- No network device: Oben links lässt sich das Interface komplett deaktivieren – nützlich für Offline-Appliances oder wenn du den Adapter erst nach der Installation hinzufügen möchtest.

Mit Back kehrst du zum RAM-Dialog zurück, Next führt zum Bestätigungs-Bildschirm, und über Advanced bekommst du weitere Optionen wie MTU-Werte oder Multiqueue angezeigt.

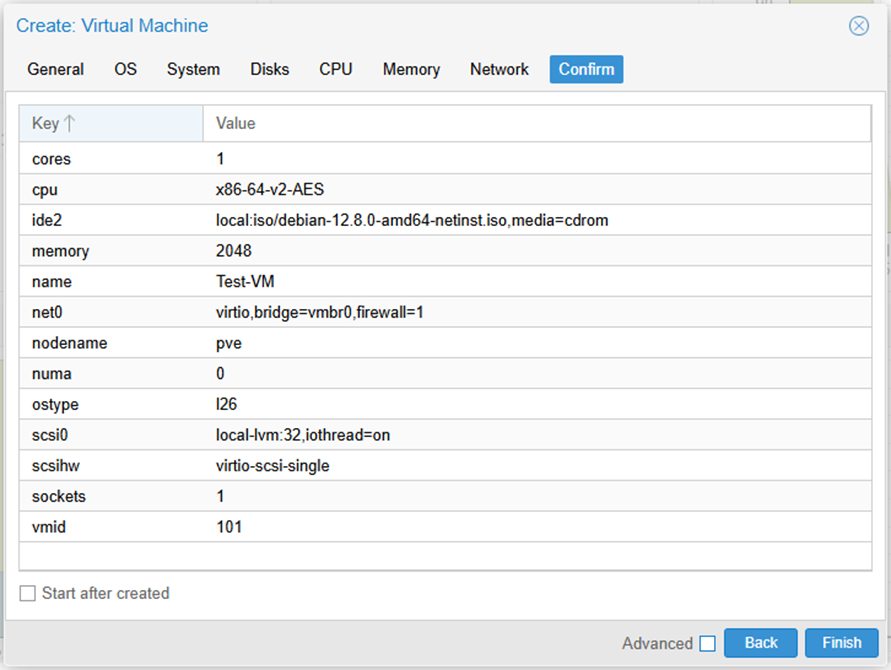

Nachdem du alle Reiter des Assistenten durchlaufen hast, präsentiert Proxmox noch einmal eine kompakte Übersicht aller gewählten Parameter – vom Namen der VM über CPU- und RAM-Zuteilung bis hin zu Storage, Netzwerk und (sofern aktiviert) Firewall-Regeln. Das ist der ideale Moment, um die Konfiguration in Ruhe zu überfliegen und Tippfehler oder vergessene Optionen zu korrigieren:

Stimmt die Disk-Größe wirklich, oder wolltest du 64 GiB statt 46 GiB?

Läuft die VM auf dem richtigen Node und im gewünschten Storage-Pool?

Hast du den VirtIO-Controller und den QEMU Guest Agent eingeplant?

Bist du zufrieden, klickst du auf Finish. Proxmox legt nun sofort die virtuelle Maschine an, erzeugt die virtuellen Laufwerke, bindet das ISO-Image ein und startet den Gast, sofern du nicht den Autostart deaktiviert hast. Parallel erscheint im Task-Log unten rechts eine Fortschrittsanzeige, sodass du live verfolgen kannst, wie die VM angelegt, registriert und schließlich hochgefahren wird.